[Review] Immersive Hackathon 2022

Nach dem erfolgreichen Auftakt im Herbst letzten Jahres fand letztes Wochenende zum zweiten Mal der Immersive Hackathon – diesmal unter dem Motto “Metaversed” statt. Vom 17.06.–18.06 durften zwanzig XR-Entwickler:innen und Planetariums-Begeisterte wieder eine komplette Nacht tüfteln, entwickeln, ausprobieren und kreativ werden.

Dazu hatten die Teams 24 Stunden Zeit sich in ihren Gruppen zu organisieren, einen Prototypen zu programmieren und ihre Präsentation vorzubereiten. Bereits Freitagmittag hatten sich die Teilnehmenden kennengelernt, ihre einzelnen Ideen und Visionen gepitcht und sich in Teams verbündet. Am Ende traten fünf Teams zwischen drei und sechs Mitgliedern gegeneinander an.

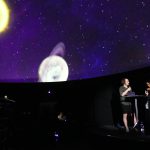

Am Samstag um 15 Uhr hieß es dann: End of Coding & Start des Juryrundgangs in den Räumlichkeiten des Kunstmuseum Bochum, in dem die Teams sich mit ihrer Technik für eine Nacht eingeschlossen hatten. Die Jury, bestehend aus Prof. Dr. Susanne Hüttemeister (Leiterin Zeiss Planetarium Bochum), Laura Saenger Pacheco (VR Spezialistin, Regisseurin und Fulldome-Enthusiastin), Thomas Riedel (Journalist & Podcaster) und Prof. Dr. Detlef Gerhard (Lehrstuhlleiter für Digital Engineering Ruhr Universität Bochum), bewertete die Projekte nach den fünf Bewertungskriterien: Potential, Kreativität, Innovationsgrad, Qualität Prototyp, Präsentation/Pitch.

In diesem Jahr durfte aber nicht nur die Jury eine Bewertung abgegeben. Die jeweils 5-minütige Präsentation in der Kuppel vor ca. 100 Personen zählte mit 50%-Gewichtung zur wichtigen Hürde. Digital konnte das Publikum für ihr Favoritenteam stimmen.

Insgesamt war sowohl die Jury, als auch das Publikum erstaunt über die Qualität der Präsentationen und der Prototypen in solch kurzer Zeit. Auch die Veranstalter vom Zeiss Planetarium Bochum waren hochzufrieden. Der technische Leiter Tobias Wiethoff lobte die Zusammenarbeite mit Places: “Wie bereits im letzten Jahr hat das Places-Team und mxr storytelling den Immersive Hackathon mit sehr viel Liebe zum Detail und hoher Professionalität organisiert und durchgeführt. An diesem Ergebnis können wir anknüpfen und im nächsten Jahr das 100. Planetariums-Jubiläum anvisieren.”

Über den 1. Platz und damit über 2000 € durfte sich das Team form follows functions mit ihrer Anwendung Shape & Color freuen. MetaView – Episode: Tiefsee räumte auf dem 2. Platz noch 1000 € ab und Team SOULPLANET freute sich über einen 3. Platz und 500 € Preisgeld. Aber auch Team Wurmloch und Planet B mussten nicht ohne Preis nach Hause: der Freundeskreis Planetarium Bochum e.V. stellte jeweils 250 € pro Team zusätzlich zur Verfügung.

Wir beschäftigen und weiter damit, wie man die Welten XR und Dome vereinen kann – dazu ist im Rahmen des Immersive Hackathon ein Discord-Channel entstanden, zu dem alle Interessierten herzlich eingeladen sind.

(c) Jule Hömberger, André Beiler und Daniel Fischer für das Planetarium Bochum

Folgende Zusammenfassungen ihrer Projekte stammen von den Teams selbst:

MetaView – Episode: Tiefsee

Finn Lichtenberg | Visual-Coder / 3D-Artist

Vesela Stanoeva | Storytelling / Sound Designerin

Elisa Drache | 3D-Artist / Grading Post Processing

Ali Hackalife | Sound Designer / 3D-Artist

Michael Cegielka | World Designer / Visual-Coder

Kurzbeschreibung des Projektes | Idee | Inhalt

Das in den letzten 24 Stunden entstandenen Projekt META VIEW ist eine neue Art das Metaverse ins Planetarium zu bringen. Das Head Mounted Display wird als ein immersives und interaktives Präsentationstool genutzt, um die Kuppel zu bespielen. Dies ermöglicht es den Reiseführenden und dem Publikum gemeinsam in ein Metaverse einzutauchen.

In der ersten Episode schwimmen wir inmitten von Partikeln, die wir leicht wahrnehmen können. Wir befinden uns in Dimensionen, die wir uns nicht vorstellen können, um Geschichten zu erzählen über was real ist und was möglich ist und was es bedeuten könnte, Unterwasser zu leben.

Wie wurde was verwendet?

Hardware | Software

Das Modeling der 3D Objekte haben wir in Blender umgesetzt und in Substance Painter texturiert, um es wiederum in Blender zu Baken. Von da aus ging die Pipeline in die Unreal Engine, um dort das finale Shading, inklusive animierte Effekte zu erzeugen. Die Interaktionen haben wir ebenfalls in der Engine erzeugt. Anschließend gab das Post Processing den finalen Schliff. Die präsentierende Person benutzt ein Head-Mounted-Display (HTC-Vive), um das Publikum durch das Metaverse zu begleiten. Die Zuschauenden

befinden sich in einer Bubble im Metaverse und können in beliebige Richtungen mitgenommen werden.

Wurmloch - Ein LIVE Blick in ein anderes Universum

Michael Koch | Planetarium, FFmpeg

Maks Hytra | Augmented Reality – SparkAR

Raphael Ntumba | Ideengebung

Viktor Waal | Augmented Reality, Pitch

Kurzbeschreibung des Projektes | Idee | Inhalt

In ein 360° Hintergrund-Video wird ein Wurmloch eingeblendet. Ein Wurmloch ist eine hypothetische Verbindung unseres Raumes zu einem anderen Punkt im Raum, zu einem anderen Zeitpunkt in der Vergangenheit beziehungsweise Zukunft oder zu einem ganz anderen Universum. Wir wissen nicht ob es tatsächlich Wurmlöcher gibt. Sie widersprechen jedenfalls nicht den Gesetzen der Physik. In unserer Simulation kommt der Inhalt des

anderen Endes des Wurmlochs in Echtzeit von einer 360° Kamera, das heißt die Besucher:innen des Planetariums können sich interaktiv selber im Wurmloch sehen. Im zweiten Teil wird ein Wurmloch als Instagram Filter für Smartphone AR über SparkAR realisiert und für die Nutzer zum ausprobieren auf dem eigenen Smartphone bereitgestellt.

Wie wurde was verwendet?

Hardware | Software

Windows-PC mit Ricoh Theta 360° Kamera,

FFmpeg-Skript,

Smartphone AR über SparkAR als Instagram-Filter

Planet B

Damian T. Dziwis | Komposition, Medienkunst, Immersive Media Engineer

Rita Below | Kommunikationsdesign, 3D Gestaltung , Programmierung

Alexander Filuk | Crossplattform-, App-, Web- und Spieleentwicklung, sensorbasierte Interaktion

Kurzbeschreibung des Projektes

Idee | Inhalt

Planet B – der Plan B Planet des Planetarium Bochum. Ein immersiver Alien-Planet mit audiovisuellen Elementen, generiert durch eine künstliche Intelligenz. Planet B lädt zum digitalen Zusammentreffen auf einer web-basierten virtuellen Plattform ein, die sich nicht nur auf das Planetarium Bochum mit seiner 360° Videosound Audio-Darbietung beschränkt, sondern auch das Publikum vor Ort sowie Menschen von überall auf der Welt in einem Metaversum verbindet. Durch VR- und AR-Systeme können Besucher:innen gemeinsam den Planeten gestalten und durch eine exklusive Steuerung im Planetarium audiovisuellen Objekten leben einhauchen.

Wie wurde was verwendet?

Hardware | Software

Rendering-Computer, Dome-Projektion,

Ambisonics-3D Audio Wiedergabe, Metaverse

Webserver, VR/AR/Mobile kompatibel,

Mobilejoypad.com, TH Köln IVES – Rendering

Engine, Blender, generative evolutionäre

KI-Netzwerke

SOULPLANET

Julian Bringezu

Sören Stölting

Olena Ronzhes

Jewgeni „Jeff“ Birkhoff

Imad el Khechen

Steffen Junginger

Kurzbeschreibung des Projektes

Idee | Inhalt

Planeten haben Seelen. Sie pulsieren lebendig oder treiben scheinbar tot durch das endlose Schwarz. Ihre Oberflächen sind fließend oder doch zerklüftet und mit Narben durchzogen.

Ihnen wohnen einzigartige Persönlichkeiten inne, so wie uns. Unsere Vision: Jeder am Planetarium Bochum bekommt in Zukunft die Möglichkeit, mit unserer Anwendung seine einzigartige Persönlichkeit in Form eines Planeten zu entdecken, zu visualisieren und zu teilen. Psychologische Fragen und Antworten stimulieren dabei visuelle Eigenschaften des Planeten.

Wie wurde was verwendet?

Hardware | Software

Domemaster

Unity

Nuendo

Shape & Color

by form follows functions

Michel Görzen | Elektrotechnik + Mikrokontroller

Cora Braun | Planetarium + Immersive Medien

Manno Ludzuweit | VR-Development + Planetarium

Joris Willrodt | VR-Development + Planetarium

Oliver Werner | Immersive Medien

Kurzbeschreibung des Projektes

Idee | Inhalt

Shape & Color ist eine interaktive Planetariums-Experience, in der das Publikum gemeinsam kleine Puzzle lösen muss. Während sie in einer futuristischen Synthwave-Röhre gefangen sind, fallen Scheiben mit verschieden positionierten Löchern auf sie herab. Mit Hilfe von Trackern, die im Publikumsbereich umhergegeben werden, können virtuelle Objekte an der Kuppel gesteuert und durch die Löcher navigiert werden. Für jedes Objekt, das erfolgreich durch eines der Löcher geschleust wurde, können Punkte erlangt werden. Je höher der Score, desto höher das Ranking der Gruppe in der Hall of Fame. Ziel der Anwendung ist die Erzeugung einer Shared Reality, an der alle Publikumsbesucher:innen bereits mit kleinen Interaktionen teilhaben können.

Wie wurde was verwendet?

Hardware | Software

Hardware: 4 Lighthouses 2.0; 4 HTC Vive Tracker 3.0; Valve Index VR Brille (nur passiv im Sleep Mode)

Software: Unity 2021.4.3.f; SteamVR; Blender; Affinity Designer

Die Tracker können innerhalb des Trackingbereiches der Lighthouses bewegt werden; die Bewegung der Tracker ist die einzige Eingabeoption für das Publikum, um die Usability der Anwendung möglichst einfach zu gestalten. Mittels Unity und Steam VR werden die Trackingdaten verarbeitet und die virtuelle Umgebung als DomeView auf die Kuppel projiziert.